Memory Ordering in Rust: Ein Leitfaden zur sicheren Nebenläufigkeit

Lukas Schneider

DevOps Engineer · Leapcell

In der nebenläufigen Programmierung ist die korrekte Verwaltung der Reihenfolge von Speicheroperationen entscheidend für die Sicherstellung der Programmkorrektheit. Rust bietet atomare Operationen und die Ordering-Enumeration, die es Entwicklern ermöglichen, gemeinsam genutzte Daten in einer Multithread-Umgebung sicher und effizient zu manipulieren. Dieser Artikel zielt darauf ab, eine detaillierte Einführung in die Prinzipien und die Verwendung von Ordering in Rust zu geben, um Entwicklern zu helfen, dieses mächtige Werkzeug besser zu verstehen und zu nutzen.

Grundlagen der Speicherreihenfolge

Moderne Prozessoren und Compiler ordnen Anweisungen und Speicheroperationen neu an, um die Leistung zu optimieren. Während diese Neuordnung in Single-Thread-Programmen normalerweise keine Probleme verursacht, kann sie in einer Multithread-Umgebung zu Datenrennen und inkonsistenten Zuständen führen, wenn sie nicht richtig gesteuert wird. Um dieses Problem zu lösen, wurde das Konzept der Speicherreihenfolge eingeführt, das es Entwicklern ermöglicht, die Speicherreihenfolge für atomare Operationen festzulegen, um eine korrekte Synchronisierung des Speicherzugriffs in nebenläufigen Umgebungen sicherzustellen.

Die Ordering-Enumeration in Rust

Die Ordering-Enumeration in Rusts Standardbibliothek bietet verschiedene Stufen von Speicherreihenfolgegarantien, die es Entwicklern ermöglichen, ein geeignetes Ordnungsmodell basierend auf spezifischen Bedürfnissen zu wählen. Im Folgenden sind die verfügbaren Speicherreihenfolgeoptionen in Rust aufgeführt:

Relaxed

Relaxed bietet die grundlegendste Garantie—es stellt die Atomizität einer einzelnen atomaren Operation sicher, garantiert aber nicht die Reihenfolge der Operationen. Dies ist geeignet für einfache Zählungen oder Zustandsmarkierungen, bei denen die relative Reihenfolge der Operationen die Korrektheit des Programms nicht beeinträchtigt.

Acquire und Release

Acquire und Release steuern die partielle Ordnung der Operationen. Acquire stellt sicher, dass der aktuelle Thread die Änderungen sieht, die durch eine übereinstimmende Release-Operation vorgenommen wurden, bevor nachfolgende Operationen ausgeführt werden. Diese werden häufig verwendet, um Sperren und andere Synchronisationsprimitive zu implementieren, um sicherzustellen, dass Ressourcen vor dem Zugriff ordnungsgemäß initialisiert werden.

AcqRel

AcqRel kombiniert die Effekte von Acquire und Release, wodurch es für Operationen geeignet ist, die sowohl Werte lesen als auch ändern, und stellt sicher, dass diese Operationen relativ zu anderen Threads geordnet sind.

SeqCst

SeqCst oder sequenzielle Konsistenz bietet die stärkste Ordnungsgarantie. Es stellt sicher, dass alle Threads Operationen in der gleichen Reihenfolge sehen, wodurch es für Szenarien geeignet ist, die eine global konsistente Ausführungsreihenfolge erfordern.

Praktische Verwendung von Ordering

Die Wahl der geeigneten Ordering ist entscheidend. Eine zu entspannte Ordnung kann zu logischen Fehlern im Programm führen, während eine zu strenge Ordnung die Leistung unnötig beeinträchtigen kann. Im Folgenden finden Sie mehrere Rust-Codebeispiele, die die Verwendung von Ordering demonstrieren.

Beispiel 1: Verwenden von Relaxed für geordneten Zugriff in einer Multithread-Umgebung

Dieses Beispiel demonstriert, wie man Relaxed-Ordering in einer Multithread-Umgebung für eine einfache Zähloperation verwendet.

use std::sync::atomic::{AtomicUsize, Ordering}; use std::thread; let counter = AtomicUsize::new(0); thread::spawn(move || { counter.fetch_add(1, Ordering::Relaxed); }).join().unwrap(); println!("Counter: {}", counter.load(Ordering::Relaxed));

- Hier wird ein atomarer Zähler

countervom TypAtomicUsizeerstellt und mit 0 initialisiert. - Ein neuer Thread wird mit

thread::spawngestartet, in dem diefetch_add-Operation auf dem Zähler durchgeführt wird, wodurch sein Wert um 1 erhöht wird. Ordering::Relaxedstellt sicher, dass die Inkrementierungsoperation atomar durchgeführt wird, aber es garantiert nicht die Reihenfolge der Operationen. Dies bedeutet, dass, wenn mehrere Threads gleichzeitigfetch_addaufcounterausführen, alle Operationen sicher abgeschlossen werden, aber ihre Ausführungsreihenfolge unvorhersehbar ist.Relaxedist geeignet für einfache Zählszenarien, bei denen wir uns nur um die endgültige Zählung kümmern und nicht um die spezifische Reihenfolge der Operationen.

Beispiel 2: Verwenden von Acquire und Release zur Synchronisierung des Datenzugriffs

Dieses Beispiel demonstriert, wie man Acquire und Release verwendet, um den Datenzugriff zwischen zwei Threads zu synchronisieren.

use std::sync::{Arc, atomic::{AtomicBool, Ordering}}; use std::thread; let data_ready = Arc::new(AtomicBool::new(false)); let data_ready_clone = Arc::clone(&data_ready); // Producer thread thread::spawn(move || { // Prepare data // ... data_ready_clone.store(true, Ordering::Release); }); // Consumer thread thread::spawn(move || { while !data_ready.load(Ordering::Acquire) { // Wait until data is ready } // Safe to access the data prepared by producer });

- Hier wird ein

AtomicBool-Flagdata_readyerstellt, um anzuzeigen, ob die Daten bereit sind, initialisiert auffalse. Arcwird verwendet, umdata_readysicher zwischen mehreren Threads zu teilen.- Der Producer-Thread bereitet Daten vor und aktualisiert dann

data_readyauftruemit der MethodestoremitOrdering::Release, was anzeigt, dass die Daten bereit sind. - Der Consumer-Thread überprüft kontinuierlich

data_readymit der MethodeloadmitOrdering::Acquirein einer Schleife, bis sein Werttruewird.- Hier werden

AcquireundReleasezusammen verwendet, um sicherzustellen, dass alle Operationen, die vom Producer durchgeführt werden, bevordata_readyauftruegesetzt wird, für den Consumer-Thread sichtbar sind, bevor er mit dem Zugriff auf die vorbereiteten Daten fortfährt.

- Hier werden

Beispiel 3: Verwenden von AcqRel für Read-Modify-Write-Operationen

Dieses Beispiel demonstriert, wie man AcqRel verwendet, um eine korrekte Synchronisierung während einer Read-Modify-Write-Operation sicherzustellen.

use std::sync::{Arc, atomic::{AtomicUsize, Ordering}}; use std::thread; let some_value = Arc::new(AtomicUsize::new(0)); let some_value_clone = Arc::clone(&some_value); // Modification thread thread::spawn(move || { // Here, `fetch_add` both reads and modifies the value, so `AcqRel` is used some_value_clone.fetch_add(1, Ordering::AcqRel); }).join().unwrap(); println!("some_value: {}", some_value.load(Ordering::SeqCst));

AcqRelist eine Kombination ausAcquireundReleaseund eignet sich für Operationen, die sowohl Daten lesen (acquire) als auch ändern (release).- In diesem Beispiel ist

fetch_addeine Read-Modify-Write-(RMW-)Operation. Es liest zuerst den aktuellen Wert vonsome_value, inkrementiert ihn dann um 1 und schreibt schließlich den neuen Wert zurück. Diese Operation stellt Folgendes sicher:- Der gelesene Wert ist der neueste, was bedeutet, dass alle vorherigen Änderungen (möglicherweise in anderen Threads vorgenommen) für den aktuellen Thread sichtbar sind (Acquire-Semantik).

- Die Änderung an

some_valueist sofort für andere Threads sichtbar (Release-Semantik).

- Die Verwendung von

AcqRelstellt sicher, dass:- Alle Lese- oder Schreiboperationen vor

fetch_addnicht danach neu angeordnet werden. - Alle Lese- oder Schreiboperationen nach

fetch_addnicht davor neu angeordnet werden. - Dies garantiert eine korrekte Synchronisierung bei der Änderung von

some_value.

- Alle Lese- oder Schreiboperationen vor

Beispiel 4: Verwenden von SeqCst zur Sicherstellung der globalen Ordnung

Dieses Beispiel demonstriert, wie man SeqCst verwendet, um eine global konsistente Reihenfolge von Operationen sicherzustellen.

use std::sync::atomic::{AtomicUsize, Ordering}}; use std::thread; let counter = AtomicUsize::new(0); thread::spawn(move || { counter.fetch_add(1, Ordering::SeqCst); }).join().unwrap(); println!("Counter: {}", counter.load(Ordering::SeqCst));

- Ähnlich wie in Beispiel 1 führt dies auch eine atomare Inkrementierungsoperation auf einem Zähler durch.

- Der Unterschied besteht darin, dass hier

Ordering::SeqCstverwendet wird.SeqCstist die strengste Speicherreihenfolge und gewährleistet nicht nur die Atomizität einzelner Operationen, sondern auch eine global konsistente Ausführungsreihenfolge. SeqCstsollte nur verwendet werden, wenn eine starke Konsistenz erforderlich ist, wie z. B.:- Zeitsynchronisation,

- Synchronisation in Mehrspieler-Spielen,

- Zustandsmaschinensynchronisation usw.

- Bei Verwendung von

SeqCstscheinen alleSeqCst-Operationen über alle Threads hinweg in einer einzigen, global vereinbarten Reihenfolge ausgeführt zu werden. Dies ist nützlich in Szenarien, in denen die genaue Reihenfolge der Operationen beibehalten werden muss.

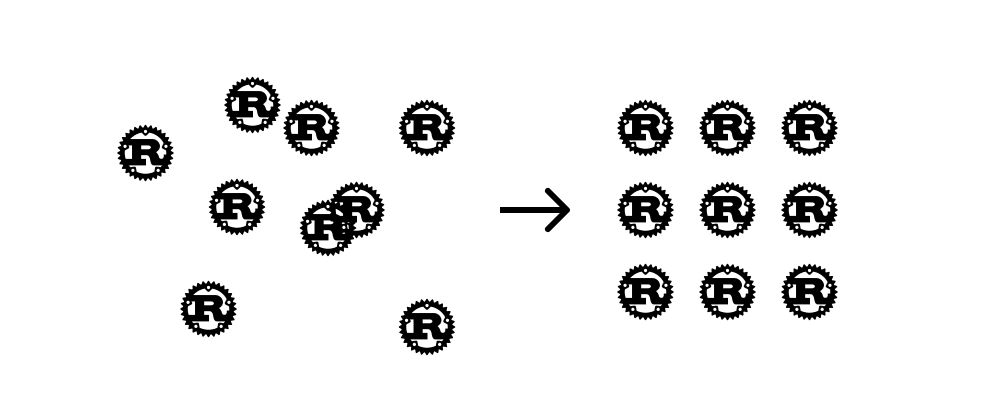

Wir sind Leapcell, deine erste Wahl für das Hosting von Rust-Projekten.

Leapcell ist die Next-Gen Serverless Plattform für Web Hosting, Async Tasks und Redis:

Multi-Language Support

- Entwickle mit Node.js, Python, Go oder Rust.

Unbegrenzt Projekte kostenlos bereitstellen

- zahle nur für die Nutzung — keine Anfragen, keine Gebühren.

Unschlagbare Kosteneffizienz

- Pay-as-you-go ohne Leerlaufgebühren.

- Beispiel: 25 $ unterstützt 6,94 Millionen Anfragen bei einer durchschnittlichen Antwortzeit von 60 ms.

Optimierte Entwicklererfahrung

- Intuitive Benutzeroberfläche für mühelose Einrichtung.

- Vollautomatische CI/CD-Pipelines und GitOps-Integration.

- Echtzeitmetriken und -protokollierung für verwertbare Erkenntnisse.

Mühelose Skalierbarkeit und hohe Leistung

- Auto-Skalierung zur einfachen Bewältigung hoher Parallelität.

- Null Betriebsaufwand — konzentriere dich einfach auf das Bauen.

Entdecke mehr in der Dokumentation!

Folge uns auf X: @LeapcellHQ